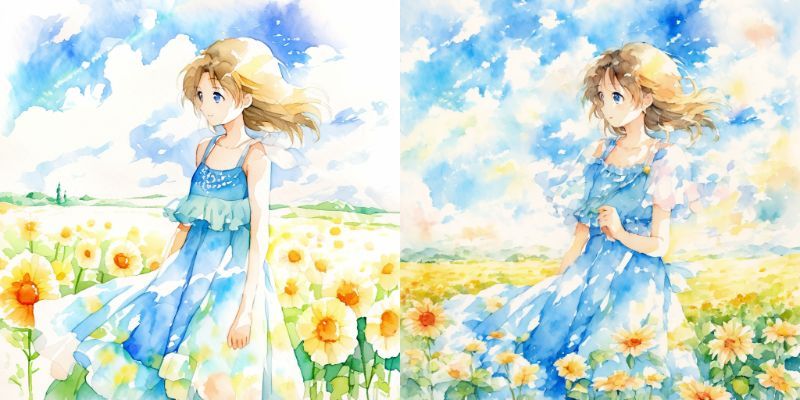

AIイラスト/少女と花畑

animagine-xl-3.1 with untitled_replicant_Lora+Aether_Watercolor_and_Ink

untitled_replicantの水彩を再現するLoraを作った

Dartを使ってお気に入りモデルuntitled_replicantの水彩を再現するLoraを作りました

右がLora適用後

untitled_replicantの特徴的な水彩の滲み・グラデ感は反映できた…かも

雑Loraだから精度は悪いけどネ

untitled_replicantは大好きなモデルなんだけど、旧いモデルなんで、animagineとか最新のSDXLモデルと比べると崩壊が多発しがち。

雑に生成すると、ラーメンを手で食ってそうな感じになる

比較的安定しているモデルを使いたい…

でも、モデルごとに学んだものが違う以上「水彩」の捉え方も違うから、同じ”watercolor”でも全然雰囲気が変わってしまう…

なので、Dartでプロンプトを量産→untitled_replicantで水彩絵を生成→Lora作成をしてみました。

さすがにまんまというワケにはいかないけど、かなり雰囲気は反映できてるかも。

Dartでテキストファイルを量産→sdapiでwebuiから生成という手順にしてます。

参考記事の通りDiffuserに直接渡してもよかったけど、これ以上インストールするものを増やしたくない

untitled_replicantはプロンプトに癖があるから都度都度修正加えたかったんで、このような手順にしました。

ただ、崩れた人体までやんわりと覚えちゃうのがね…

精度よくするならなら、片っ端から生成画像を加筆する必要があって、そんなんやってられんので妥協してます。

作成Loraを用いた生成物でさらにLoraを作成するのも試したけど……不思議と別物になっちゃうんですよね。

untitled_replicant100%じゃないとダメみたい。やっぱり見えざる傾向というのもがあるんだなあ。

ひとりごと。

「モデルを変えると画風も構図の傾向も変わる」というのが昔の生成モデルの常識だったと思うんですけど…

animagineなどの最新モデル使ってると、プロンプトへの忠実度の向上に伴う「一般的なイメージへの収束」を強く感じます。

左 untitled_replicant

右 animagine 同プロンプトで人物へInpaint(絵の一部を描き替え)したもの

デッサンは狂いにくいけど「どっかで見た感」がかなりあるんですね。

過去の美化もあると思うんですが、旧いモデルは「要素が混じりあっている」感じがあり、たとえば「王様」とプロンプトに入っていたら、絵のどこにも王っぽい要素が混ぜ込まれてしまうんですよね。

それは生成物が指示の意図から離れることを誘発する一方、生成AIにしか作れない、おもしろいキメラを出してくれることに繋がっていたような?

いまは、プロンプト通りの絵が出る。Crownとかつけないと、ただの少女が冠をつけたりしない。

狙ったものは出しやすいけど、アイデアがないとどっかで見たようなものしか出てこない…

いいことではあるんだけど~!!!

ツールとしては正しいけど、ちょっと複雑。

生成AIは描いているか

AI生成でのイラスト生成って、体感、イラスト生成というよりグラフィック生成のように感じています。

イラストを描いているというより、ピクセル情報の群体を指揮しているみたいな…

そこに加筆が加わると一気にわけわかんなくなるけども。

「描く」が「脳内にあるイメージを整え、魅力的な形に変換すること」であるなら、生成AIはある意味では描いてはいない。

出力過程にLoraなりcontrolnetなり、長崎春のinpaint祭りで人間が介入することで、「描く」になる(創造性が生まれる?)ともいえるのではないかと思うん。

もちろん、手書きでの「描く」とはまったく別物であり、ぶっちゃけ労力は手描きのほうがそりゃ上やろ、とは思うておりますけども…

でも極端な話、法律上では、写真にも創造的寄与があるように、生成されたイラストに意味を見出したらそこには創造性があるともいえる。ややこしくて不思議な話だけども。

いきなり哲学的な話になってたけど、じゃあ生成AIが「描く」にはどうすればいいのか?

AnimateDiffとか眺めていて思うことは、今の画像生成AIに足りないのは「目」な気がするんですよね。

まだ絵を認識する能力そのものは低い。AI自身で生成したイラストならうまく動かせるけど、既存のイラストに適用ができていない。

たとえば、絵に描かれた道路を認識して、道路としておかしい部分を「考えて」修正することはまだできない。inpaintで修正できるけど「道路を描いてある絵には一般的にない部分」を描き変えてるだけ。

そもそも、AIはデフォルメはできても、「目の前にあるものをデフォルメ化する」にまで達していない。

たとえば、「最低限の線で表現されたバナナの絵」は知ってても、「バナナを他の人にも伝わるように最低限の線で表現する」ことはまだできない。

っていうかCannyだって、あれは特徴量のedgeを出してるだけで、「線画」とは似て非なるもの。概念と概念の間に線を引くことはAIにはまだできねえっすよ。

今の画像生成AIは筆と脳内イメージがあって、直接イメージを出力している。

ただ、出力はそれっぽいから、人間と同じ「描く」ができているように見えているだけな気がするんです。

どうあがいても人間を経由するから、振る舞いが似ているだけだと看破されていない、みたいな。

うまく認識し、うまくそり落とす、配置する。

ここまでをAI自らが意図してやることはまだできないから、「まだ生成AIは人間のように「描く」ことはできない、その域には至っていない」と言っちゃっても大丈夫な気がするんです。

正直、出力だけ見るなら危険視されても仕方ないとは思いはしますけどね…

表面上は同じ手書きにしか見えないから、AIイラストがなかった世界の我々が混乱するのも当たり前で。

AIイラストはイラストというよりグラフィックだし、でもこの技術は間違いなくイラストレーションにも関わるから話がややこしい…。

私は「AI」でイラストを(グラフィックを)生成するのが好きなだけであって、描くことを省略する意図はないんだけど、正直、AIの絵がうますぎて嫌だな~て思うことはあります。

だから、こういうのもなんだけど、比較的あまり上手くない(出た当時は高性能だったけど!)untitled_replicantに固執してるんだろうな~。

それでも上手いよね。こわい。

自作絵を用いたミニアニメ化とか手軽にできるようになれば界隈の温度感も変わってきそうな気がするんだけど、まだまだ難しい…

イラストからdepthを取ったりとか、「イラストの中にある世界をAIも認識できる」ってすごいことだと思うんですけどね。

私だって神絵師の描いた世界で旅したいよ。

「「花瓶の絵」に花を挿すことができるようになる」って、けっこう夢のある話だと思うんだけど、なかなかこの可能性が上手く伝えられないな…

Loraを適用したテスト画像の拡大版。こういう水彩画もすき。